Es Google Cloud Next en Las Vegas esta semana, y eso significa que es hora de que lleguen a la plataforma Google Cloud una serie de nuevos tipos de instancias y aceleradores. Además de los nuevos chips Axion personalizados basados en Arm, la mayoría de los anuncios de este año se centran en aceleradores de IA, ya sea construidos por Google o por Nvidia.

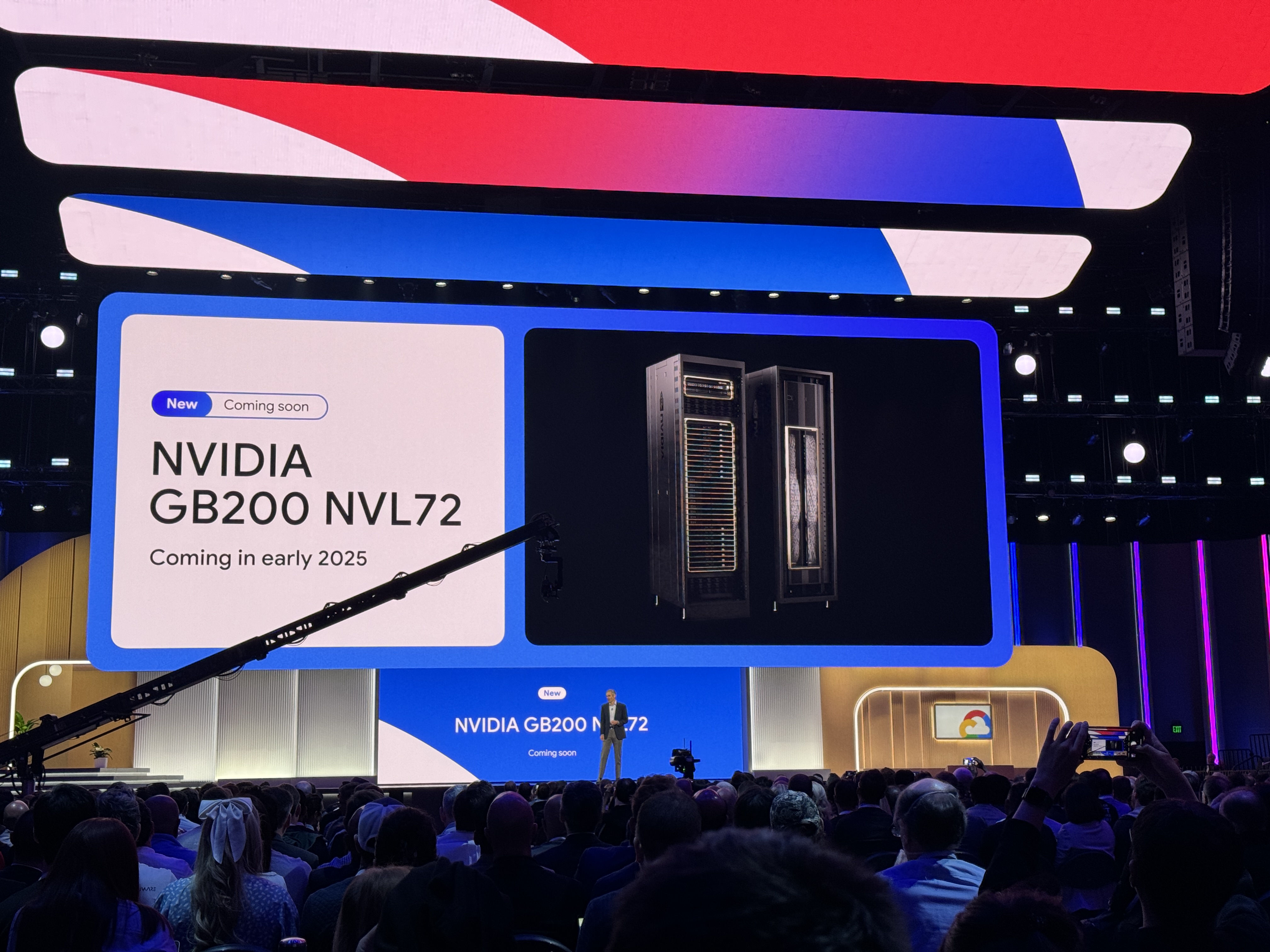

Hace solo unas semanas, Nvidia anunció su plataforma Blackwell. Pero no espere que Google ofrezca esas máquinas pronto. El soporte para el alto rendimiento de Nvidia HGX B200 para cargas de trabajo de IA y HPC y GB200 NBL72 para el entrenamiento de modelos de lenguaje grande (LLM) llegará a principios de 2025. Un dato interesante del anuncio de Google: los servidores GB200 estarán refrigerados por líquido.

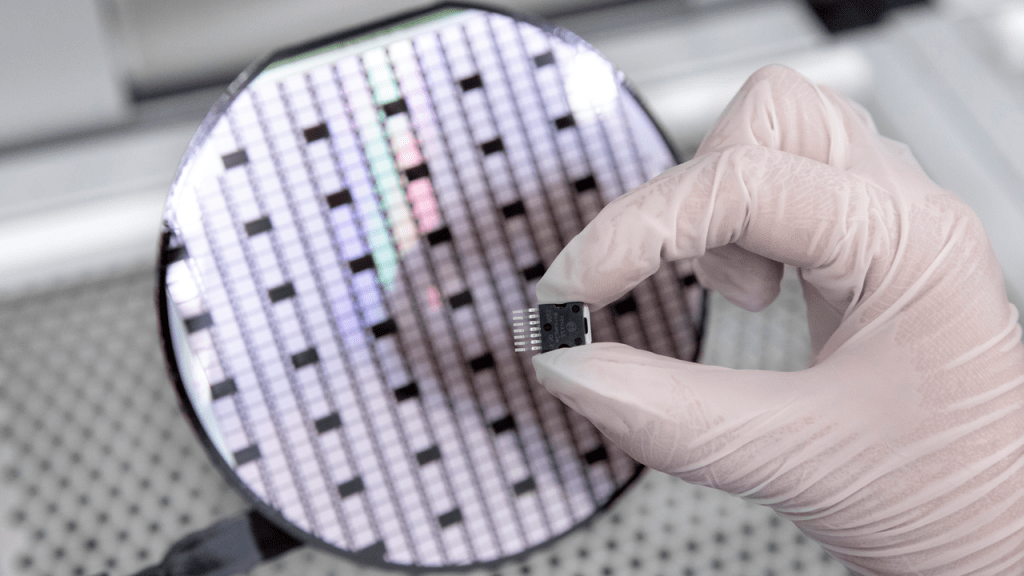

Esto puede sonar como un anuncio un poco prematuro, pero Nvidia dijo que sus chips Blackwell no estarán disponibles públicamente hasta el último trimestre de este año.

Antes de Blackwell

Para los desarrolladores que necesitan más potencia para entrenar LLMs hoy, Google también anunció la instancia A3 Mega. Esta instancia, que la compañía desarrolló junto con Nvidia, presenta las GPU H100 estándar de la industria pero las combina con un nuevo sistema de redes que puede ofrecer hasta el doble de ancho de banda por GPU.

Otra nueva instancia A3 es A3 confidencial, que Google describió como permitiendo a los clientes 'proteger mejor la confidencialidad e integridad de los datos sensibles y las cargas de trabajo de IA durante el entrenamiento y la inferencia'. La compañía ha ofrecido durante mucho tiempo servicios de informática confidencial que cifran los datos en uso, y aquí, una vez habilitada, la informática confidencial cifrará las transferencias de datos entre la CPU de Intel y la GPU H100 de Nvidia a través de PCIe protegido. No se requieren cambios en el código, según Google.

En cuanto a los chips propios de Google, la compañía lanzó el martes sus procesadores Cloud TPU v5p, los aceleradores de IA de desarrollo propio más potentes hasta la fecha, en disponibilidad general. Estos chips ofrecen una mejora del 2x en operaciones de punto flotante por segundo y una mejora del 3x en la velocidad del ancho de banda de memoria.

Todos esos chips rápidos necesitan una arquitectura subyacente que pueda seguirles el ritmo. Por lo tanto, además de los nuevos chips, Google también anunció el martes nuevas opciones de almacenamiento optimizadas para la IA. Hyperdisk ML, que ahora está en vista previa, es el servicio de almacenamiento de bloques de próxima generación de la compañía que puede mejorar los tiempos de carga del modelo hasta en 3.7 veces, según Google.

Google Cloud también está lanzando una serie de instancias más tradicionales, alimentadas por los procesadores Intel de cuarta y quinta generación Xeon. Las nuevas instancias de propósito general C4 y N4, por ejemplo, contarán con los Xeons de la quinta generación Emerald Rapids, con el C4 centrado en el rendimiento y el N4 en el precio. Las nuevas instancias C4 ahora están en vista previa privada, y las máquinas N4 están disponibles ahora.

También nuevo, pero aún en vista previa, son las máquinas bare-metal C3, alimentadas por los antiguos Xeons de cuarta generación de Intel, las instancias bare metal optimizadas para memoria X4 (también en vista previa) y la Z3, la primera máquina virtual optimizada para almacenamiento de Google Cloud que promete ofrecer 'el mayor IOPS para instancias optimizadas para almacenamiento entre los principales clouds'.

La keynote de Nvidia en GTC tuvo algunas sorpresas